ダイナミックプライシングの仕組み|需要予測アルゴリズムを解説

AIサマリー

ダイナミックプライシングを支える需要予測アルゴリズムを技術者向けに解説。ARIMA、LSTM、Transformerの使い分けと実装の注意点。

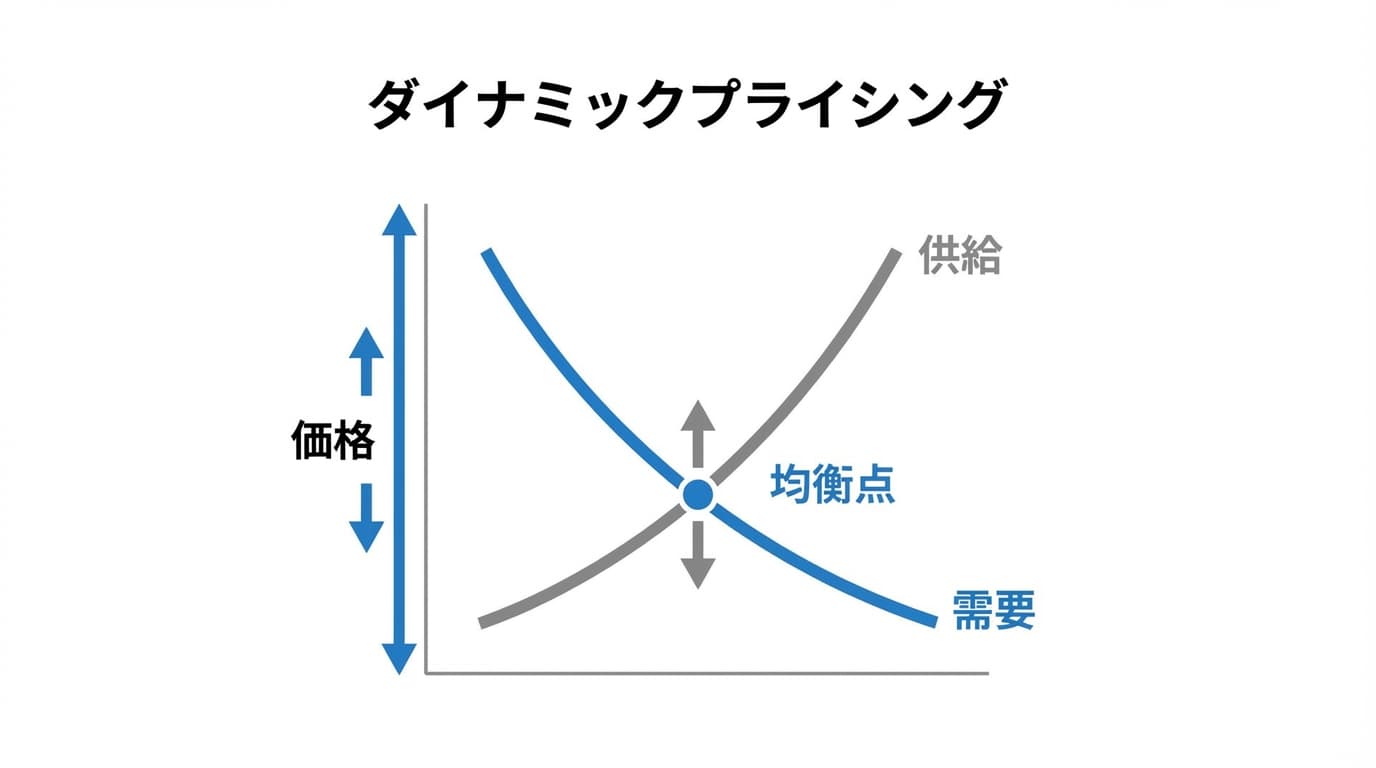

ダイナミックプライシングの精度は、需要予測アルゴリズムの性能で決まります。

Gartnerの2024年調査によると、機械学習を活用した需要予測は、最初の12週間で過剰在庫を**10-25%削減。ホテル業界では、RevPAR(客室単価)が7.5-10%**向上しています。

本記事では、ダイナミックプライシングを支える技術構成と、主要アルゴリズムの特徴・使い分けを解説します。

この記事でわかること

- 技術構成: データ収集から価格反映までのアーキテクチャ

- アルゴリズム: ARIMA、LSTM、Transformerの特徴と使い分け

- 実装の注意点: オーバーフィッティング回避、A/Bテスト設計

基本情報

| 項目 | 内容 |

|---|---|

| トピック | 需要予測アルゴリズムの技術解説 |

| カテゴリ | プライシング技術 |

| 難易度 | 中級〜上級 |

| 対象読者 | データサイエンティスト、技術リーダー |

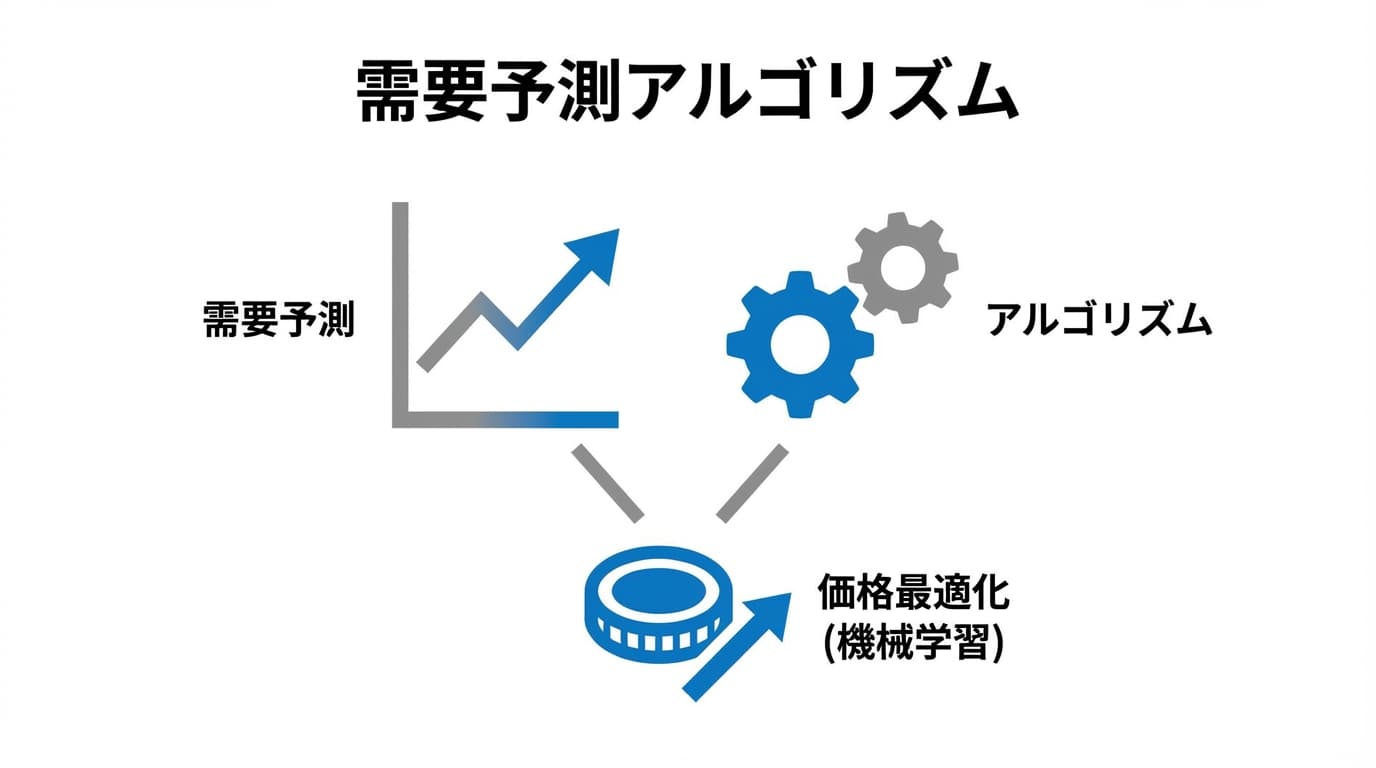

ダイナミックプライシングの技術構成

4層アーキテクチャ

ダイナミックプライシングシステムは、以下の4層で構成されます。

| 層 | 役割 | 主要技術 |

|---|---|---|

| データ収集層 | 内部・外部データの取得 | ETL、API連携、スクレイピング |

| 分析層 | 需要予測、価格弾力性分析 | ML/DLモデル、統計分析 |

| 意思決定層 | 最適価格の算出 | 最適化アルゴリズム、ビジネスルール |

| 実行層 | 価格の反映 | API、CMS連携、A/Bテスト |

必要なデータソース

需要予測の精度は、入力データの質と量に依存します。

内部データ:

- 販売履歴(時系列)

- 在庫推移

- 顧客セグメント別購買パターン

- マーケティング施策履歴

外部データ:

- 競合価格

- 天気・気温

- イベント・祝日カレンダー

- 経済指標(消費者物価指数など)

- Googleトレンド・SNSセンチメント

従来の需要予測手法

ARIMA(自己回帰和分移動平均)

ARIMAは、時系列予測の古典的手法です。

モデル構成:

- AR(自己回帰): 過去の値から現在を予測

- I(和分): 差分を取って定常化

- MA(移動平均): 過去の誤差から現在を予測

パラメータ: ARIMA(p, d, q)

- p: 自己回帰の次数

- d: 差分の回数

- q: 移動平均の次数

予測値 = φ₁×Y(t-1) + φ₂×Y(t-2) + ... + θ₁×ε(t-1) + θ₂×ε(t-2) + ...

メリット:

- 解釈性が高い

- 計算コストが低い

- 少量データでも動作

デメリット:

- 線形関係のみ捕捉

- 外部変数の組み込みが困難

- 長期予測が不安定

SARIMA(季節性ARIMA)

SARIMAは、ARIMAに季節性を追加したモデルです。

パラメータ: SARIMA(p, d, q)(P, D, Q)s

- (P, D, Q): 季節性成分

- s: 季節周期(月次なら12、週次なら7)

ホテルや航空など、季節性が明確な業界で有効です。

Prophet(Meta/Facebook)

ProphetはMeta(旧Facebook)が開発した時系列予測ライブラリです。

特徴:

- トレンド、季節性、祝日を自動分解

- 欠損値に強い

- ハイパーパラメータ調整が容易

from prophet import Prophet

model = Prophet()

model.fit(df)

future = model.make_future_dataframe(periods=30)

forecast = model.predict(future)

適用場面:

- 中規模のデータセット

- 季節性と祝日効果が重要

- 解釈性を重視

機械学習アプローチ

Gradient Boosting(XGBoost、LightGBM)

Gradient Boostingは、複数の弱学習器を組み合わせるアンサンブル手法です。

特徴:

- 非線形関係を捕捉

- 特徴量エンジニアリングの自由度が高い

- 競合価格、天気など外部変数を組み込みやすい

import lightgbm as lgb

params = {

'objective': 'regression',

'metric': 'rmse',

'num_leaves': 31,

'learning_rate': 0.05

}

model = lgb.train(params, train_data, valid_sets=[valid_data])

predictions = model.predict(test_features)

メリット:

- 高精度

- 特徴量重要度が取得可能

- 比較的高速

デメリット:

- 時系列の長期依存を捉えにくい

- 特徴量エンジニアリングが必要

LSTM(Long Short-Term Memory)

LSTMは、RNN(再帰型ニューラルネットワーク)の改良版で、長期依存を学習できます。

特徴:

- ゲート機構で長期記憶を保持

- 時系列パターンを自動学習

- 可変長の入力に対応

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

model = Sequential([

LSTM(50, activation='relu', input_shape=(n_steps, n_features)),

Dense(1)

])

model.compile(optimizer='adam', loss='mse')

model.fit(X_train, y_train, epochs=50, batch_size=32)

適用場面:

- 時系列パターンが複雑

- 長期的なトレンドの学習が必要

- 大量のデータがある

Temporal Fusion Transformers(TFT)

TFTは、Transformerアーキテクチャを時系列予測に応用したモデルです。

特徴:

- Attention機構で重要な時点を識別

- 静的・動的な変数を柔軟に扱える

- 予測の解釈性が高い(Attention可視化)

メリット:

- 最新のState-of-the-Art

- 複数の時系列を同時に学習(マルチホライズン)

- 不確実性の定量化が可能

デメリット:

- 計算コストが高い

- 大量のデータが必要

- 実装の複雑さ

ルールベース vs 機械学習

比較表

| 観点 | ルールベース | 機械学習 |

|---|---|---|

| 精度 | 中程度 | 高い |

| 計算コスト | 低い | 高い |

| 解釈性 | 高い | 低い(ブラックボックス) |

| 導入障壁 | 低い | 高い(専門人材必要) |

| 変化への適応 | 遅い(ルール更新必要) | 速い(自動学習) |

使い分けの指針

| 状況 | 推奨アプローチ |

|---|---|

| SKU数が少ない(〜100) | ルールベース |

| SKU数が多い(1,000+) | 機械学習 |

| データ量が少ない | ルールベース / Prophet |

| データ量が豊富 | Gradient Boosting / LSTM |

| 解釈性が重要 | ルールベース / Prophet |

| 精度最優先 | TFT / アンサンブル |

ハイブリッドアプローチ

実務では、ルールベースと機械学習を組み合わせるハイブリッドアプローチが有効です。

- 機械学習で需要を予測

- ルールで制約を適用(最低価格、利益率下限、変動幅上限)

- ビジネス判断でオーバーライド(キャンペーン、在庫処分)

外部データの活用

有効な外部データソース

| データ | 影響する業界 | 取得方法 |

|---|---|---|

| 天気・気温 | 小売、飲食、レジャー | API(OpenWeatherMap等) |

| イベント・祝日 | ホテル、航空、エンタメ | カレンダーAPI |

| 経済指標 | 全般 | 政府統計、FRED |

| Googleトレンド | EC、観光 | Google Trends API |

| 競合価格 | EC、小売 | スクレイピング、価格モニタリングツール |

データ品質の課題

外部データ活用には課題もあります。

- 欠損値: 天気データの欠落、祝日の地域差

- 遅延: リアルタイム性の確保

- ノイズ: SNSセンチメントの信頼性

- コスト: 有料データソースの費用

実装時の注意点

1. オーバーフィッティングの回避

過去データに過度に適合すると、将来予測が不安定になります。

対策:

- クロスバリデーション(時系列用)

- 正則化(L1/L2)

- Early Stopping

- ドロップアウト(ニューラルネット)

2. A/Bテストの設計

価格変更の効果を正確に測定するには、適切なA/Bテスト設計が必要です。

注意点:

- 顧客のランダム割当

- 十分なサンプルサイズ

- 季節性の考慮(同期間比較)

- カニバリゼーションの監視

3. 説明可能性の確保

「なぜこの価格なのか?」を説明できることが、実務では重要です。

アプローチ:

- 特徴量重要度(Gradient Boosting)

- Attention可視化(Transformer)

- SHAP値(モデル非依存の説明)

よくある質問(FAQ)

Q1. 自社開発 vs 既製ツール?

自社の技術力とリソースに依存します。既製ツール(RMS、リプライサー)は導入が早く、サポートも受けられます。自社開発は柔軟性が高いですが、専門人材と継続的な保守が必要です。

Q2. 必要なデータ量は?

機械学習モデルには最低1-2年分の日次データが推奨されます。LSTMやTFTはさらに多くのデータ(3年以上)で性能が向上します。

Q3. 精度はどこまで上げられる?

業界やデータ品質により異なりますが、MAPE(平均絶対誤差率)10-20%程度が現実的な目標です。Cloudbeds(ホテルRMS)は90日先の予測で95%精度を謳っています。

まとめ

主要ポイント

- 従来手法: ARIMA、SARIMA、Prophetは解釈性が高く、少量データでも動作

- 機械学習: Gradient Boosting、LSTM、TFTは高精度だが、データ量と専門知識が必要

- 実務: ハイブリッドアプローチ(ML予測 + ルール制約)が現実的

次のステップ

- 自社データの量と質を評価する

- Prophetで簡易的な需要予測を試す

- 精度が不十分なら、Gradient BoostingやLSTMを検討

参考リソース

学術

実践

- Prophet Documentation - Meta

- AI Demand Forecasting Guide - MobiDev

- Gartner Market Guide for AI Demand Forecasting

本記事はダイナミックプライシングシリーズの一部です。

この記事の著者

猪良 幸太郎

東京理科大学卒業後、国内独立系コンサルティングファームに入社し、IT・業務コンサルタント兼マネージャーとして業務最適化やシステム導入プロジェクトを経験。その後プライシングスタジオに入社し、執行役員兼ビジネス本部長として顧客のプライシング変革支援をリードする傍ら、自社の新規事業立ち上げの推進にも従事。